音声認識とは正確には何ですか?

音声認識

音声認識について知っておくべきこと

私たちが音声認識について話しているとき、通常、私たちは話された単語を認識し、それをプログラムに書き留める能力を持っているソフトウェアを意味します。 「音声認識」とも呼ばれます。当初、そのソフトウェアの可能性は非常に限られていたため、限られた数のフレーズしか変換できませんでした。時間の経過とともに、音声認識ソフトウェアの背後にあるテクノロジーは大きく発展し、今でははるかに洗練されているため、さまざまな言語やさまざまなアクセントを認識できます。しかしもちろん、この分野で行う必要のある作業はまだあります。

また、2つの用語を同じものに使用することもありますが、音声認識は音声認識と同じではないことに注意することも重要です。音声認識は、話している人を識別するために使用され、話していることに注意する必要はありません。

音声認識と関連技術の短い歴史

この記事では、音声認識の台頭の背後にある歴史と技術について簡単に説明します。

デジタル時代の幕開け以来、人々はどういうわけか機械と通信できるようになりたいという衝動を持っていました。最初の種類のデジタルコンピュータが発明された後、多くの科学者やエンジニアがさまざまな方法でこのプロセスに音声認識を実装しようと試みました。このプロセスの重要な年は1962年で、IBMが簡単な数学計算を実行できる基本的な音声認識マシンであるShoeboxを発表しました。このプロトコンピューターのユーザーがマイクに向かって話すと、このマシンは「プラス」や「マイナス」などの最大6つの制御ワードを認識できました。時間の経過とともに、この背後にあるテクノロジーが開発され、今日では、音声でコンピューターと対話することが非常に一般的な機能になっています。 SiriやAlexaのような有名な音声認識エンジンはたくさんあります。これらの音声駆動デバイスは、人工知能(AI)と機械学習に依存していることに注意することが重要です。

人工知能(AI)と言えば、まるでサイエンスフィクションの映画のように聞こえるかもしれませんが、実は今日の時代、AIは私たちの世界で大きな役割を果たしています。実際、多くのプログラムやアプリがすでにAIを使用しているため、AIはすでに私たちの日常生活に非常に存在しています。しかし、この用語が登場したのは20世紀初頭の空想科学小説でした。 1950年後半に、AIの概念がより顕著になり、多くの科学者や哲学者の関心の的となりました。当時、アラン・チューリングと呼ばれる非常に野心的な英国の数学者は、入手可能な情報の入力に基づいて、機械が問題を解決し、自分で決定を下すことができるという提案を思いつきました。問題は、コンピューターがそのデータを記憶する可能性をまだ持っていないことでした。これは、人工知能の開発にとって重要なステップです。当時彼らができることは、単純なコマンドを実行することだけでした。

AIの開発におけるもう1つの重要な名前は、まさに「人工知能」という用語を最初に作り出したジョン・マッカーシーです。マッカーシーは、AIは「インテリジェントマシンを作るための科学と工学」であると述べました。この定義は、1956年にダートマス大学で開催された独創的な会議で明らかになりました。それ以降、AIは必死のペースで発展し始めました。

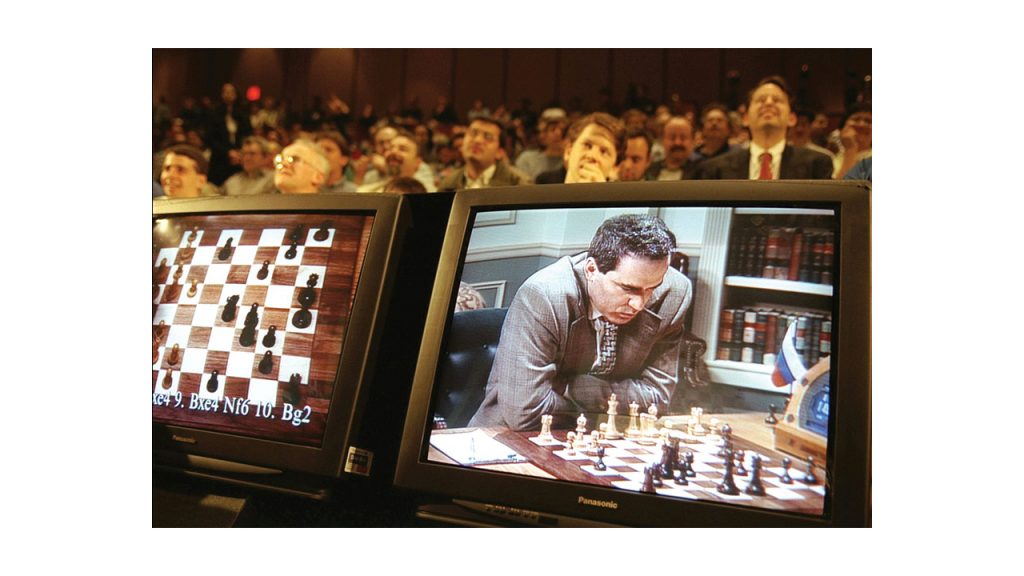

今日、さまざまな形の人工知能がいたるところに存在しています。これは、主に世界中で毎日交換されるデータの全体的な量の増加により、大量に採用されるまでに成長しました。高度なアルゴリズムで使用され、ストレージと計算能力の向上をもたらしました。 AIは、翻訳、文字起こし、音声、顔とオブジェクトの認識、医療画像の分析、自然言語の処理、さまざまなソーシャルネットワークフィルターなど、さまざまな目的で使用されます。グランドマスターのガリカスパロフとディープブルーのチェスAIのチェスの試合を覚えていますか?

機械学習は、人工知能のもう1つの非常に重要なアプリケーションです。要するに、それは彼ら自身の経験のデータベースから学びそして改善する能力を持っているどんなシステムも指します。これは、パターンの認識を通じて機能します。システムがそれを行うには、トレーニングできる必要があります。システムのアルゴリズムは大量のデータの入力を受け取り、ある時点でそのデータからパターンを識別できるようになります。このプロセスの最終目標は、人間の介入や支援を必要とせずに、これらのコンピューターシステムが独立して学習できるようにすることです。

機械学習と並んで言及することが非常に重要なもう1つのことは、ディープラーニングです。ディープラーニングのプロセスで最も重要なツールの1つは、いわゆる人工ニューラルネットワークです。それらは、人間の脳の構造と機能に似た高度なアルゴリズムです。ただし、プラスチックでよりアナログベースの生物学的脳とは異なり、それらは静的で象徴的です。要するに、この深層学習は、主に人工ニューラルネットワークに基づく非常に特殊な機械学習の方法です。ディープラーニングの目標は、人間の学習プロセスを厳密に再現することです。ディープラーニング技術は非常に有用であり、タブレット、テレビ、スマートフォン、冷蔵庫など、音声で制御されるさまざまなデバイスで重要な役割を果たします。人工ニューラルネットワークは、アイテムを予測することを目的とした一種のフィルタリングシステムとしても使用されます。ユーザーが将来購入すること。ディープラーニング技術は、医療分野でも非常に広く使用されています。がん細胞を自動的に検出するのに役立つため、がん研究者にとって非常に重要です。

次に、音声認識に戻ります。このテクノロジーは、すでに述べたように、話されている言語のさまざまな単語やフレーズを識別することを目的としています。その後、それらをマシンが読み取れる形式に変換します。基本的なプログラムは少数のキーフレーズしか識別しませんが、一部のより高度な音声認識ソフトウェアは、あらゆる種類の自然な音声を解読できます。ほとんどの場合、音声認識技術は便利ですが、録音の品質が十分でない場合や、スピーカーを正しく理解するのが難しいバックグラウンドノイズがある場合に問題が発生することがあります。また、話者のアクセントや方言が非常に強い場合でも、問題が発生する可能性があります。音声認識は絶えず発展していますが、それでも完全ではありません。すべてが言葉であるわけではありません。機械は、人間ができる多くのことをまだ実行できません。たとえば、ボディランゲージや誰かの声のトーンを解読することはできません。ただし、これらの高度なアルゴリズムによってより多くのデータが解読されるにつれて、これらの課題のいくつかは難易度が低下するようです。未来が何をもたらすか誰が知っていますか?音声認識がどこで終わるかを予測するのは難しいです。たとえば、GoogleはすでにGoogle翻訳エンジンに音声認識ソフトウェアを実装することに多くの成功を収めており、マシンは常に学習と開発を続けています。多分いつか彼らは人間の翻訳者を完全に置き換えるでしょう。あるいはそうではないかもしれませんが、日常の会話の状況は、人間の魂の深さを読み取ることができないあらゆる種類のマシンには複雑すぎます。

いつ音声認識を使用しますか?

今日では、ほとんどの人がスマートフォンやタブレットを持っています。音声認識は、これらのデバイスの一般的な機能です。それらは、人のスピーチを行動に変換するために使用されます。祖母に電話をかけたい場合は、「おばあちゃんに電話」とコマンドを送信するだけで十分です。連絡先リストに入力しなくても、スマートフォンはすでに番号をダイヤルしています。これが音声認識です。もう1つの良い例は、AlexaまたはSiriです。また、この機能はシステムに組み込まれています。 Googleには、何も入力せずに音声で何かを検索するオプションもあります。

たぶん、あなたは今、これらすべてがどのように機能するかについて興味があります。それが機能するためには、マイクのようなセンサーがソフトウェアに組み込まれている必要があります。そうすれば、話し言葉の音波が認識され、分析され、デジタル形式に変換されます。次に、デジタル情報を、ある種の単語や表現のリポジトリに保存されている他の情報と比較する必要があります。一致する場合、ソフトウェアはコマンドを認識し、それに応じて動作します。

この時点で言及する必要があるもう1つのことは、いわゆるWER(単語誤り率)です。これは、エラー数を単語の合計で割る式です。つまり、簡単に言えば、精度と関係があります。もちろん、目標はWERを低くすることです。これは、話し言葉の書き起こしがより正確であることを意味するためです。

音声認識の需要は、これまで以上に高まっています。録音された音声ファイルから話された言葉をテキストに変換する必要がある場合は、Gglot をご利用ください。当社は、適正な価格で正確な文字起こしを提供する文字起こしサービス プロバイダーです。当社の使いやすい Web サイトから、お気軽にお問い合わせください。